I. 서 론

II. 실험방법

2.1 모의 데이터 생성

2.2 딥러닝 기법 및 적용 모델

2.3 실해역 데이터

2.4 실험환경

2.5 모델 성능 평가 지표

III. 실험결과

3.1 모의 데이터 학습 모델 성능 평가

3.2 실해역 데이터 예측 결과

IV. 요약 및 결론

I. 서 론

수중환경에서 수동 소나를 이용한다면, 선박이 방사하는 소음을 수신하여 선박의 특성을 분석하고, 분석한 정보를 가지고 선박 식별이 가능하다. 수동 소나에 수신된 선박 방사소음은 기계류 소음, 유체 소음, 프로펠러 소음으로 분류된다.[1] 이 중 프로펠러 소음은 프로펠러의 회전으로 발생하는 소음으로, 프로펠러가 고속으로 회전할 때 캐비테이션 현상이 발생하여 진폭 변조된 광대역 캐비테이션 소음이 선박에서 방사된다. 방사된 소음은 Detection of Envelope Modulation On Noise(DEMON) 분석을 수행하여 선박의 프로펠러축 회전수(Propeller Shaft Rate, PSR), 날개 회전수(Blade Rate, BR) 등의 선박 정보를 확인할 수 있고, 이를 활용하여 선박 식별과 분류를 할 수 있다.[2,3]

이와같이 선박 방사소음을 분석하는 데 주로 사용되는 DEMON 기법 성능을 개선하기 위한 연구가 지속적으로 진행되고 있다. Kim et al.[4]은 선박 방사소음 중 기계류 소음의 간섭을 최소화하여 DEMON 분석을 수행하였고, Cheong et al.[5]은 DEMON 분석 단계 중 대역통과 필터 단계에서 대역 분할 처리를 수행하여 DEMON 기법의 성능을 높인 방법을 제시하였다. 하지만 신호대잡음비(Signal-to-Noise Ratio, SNR)가 낮은 환경에서는 DEMON 그램 분석에 어려움이 존재하는데, 이는 DEMON 그램에 존재하는 주변 소음 및 PSR, BR 정보가 담겨있는 표적 주파수선의 낮은 신호 세기로 인하여 발생한다.

이를 개선하기 위해 최근 딥러닝 기법 중 이미지를 픽셀 단위로 구분하여 각 픽셀이 어느 객체인지 분할하는 의미론적 분할 기법을 사용하여 이미지 내 표적 분리 및 추출하는 연구가 진행되고 있다.[6,7] Shin et al.[8]은 의미론적 분할 기법을 사용하여 저탐지 환경에서 Bearing-Time Records(BTR) 다이어그램의 표적 방위각 궤적을 추출하는 모델을 제안하였으며, 제안한 모델은 모델 학습에 필요한 정답 이미지를 간단하게 만들 수 있는 모의 BTR 다이어그램 데이터만을 사용하여 모델 학습과 성능 검증을 수행하였다. Jin et al.[9]은 딱총새우가 존재하는 환경에서 해양 포유류 신호를 녹음한 후 스펙트로그램 내 해양 포유류 신호를 표적으로 설정하고, 의미론적 분할 기법이 적용된 모델을 사용하여 표적을 추출하였다. 이 연구에서는 스펙트로그램 내 표적을 수동으로 추출하여 모델 학습에 필요한 정답 이미지를 제작하였는데, 이는 데이터셋을 구축하는 데 많은 시간이 소요되는 문제가 발생한다.

따라서 본 논문에서는 선박 식별 및 분류가 어려운 낮은 SNR 환경에서 DEMON 그램 내 PSR, BR 정보가 담겨있는 표적 주파수선을 딥러닝 기법 중 의미론적 분할을 사용하여 추출하고자 한다. 이를 위해 모의 DEMON 그램 이미지와 정답 이미지를 사용하여 모델 학습을 수행하고, 실해역 데이터를 학습된 모델에 넣어 표적 주파수선의 추출 성능을 확인하였다.

본 논문의 구성은 다음과 같다. II장에서는 모델 학습에 사용된 모의 데이터와 논문에서 사용한 딥러닝 기법과 모델 그리고 실해역 데이터에 대해 설명한다. 그 후 실험환경과 모델 평가 지표에 대해 설명한다. III장에서는 모의 데이터와 실해역 데이터의 모델 적용 결과를 분석 및 비교한다. IV장에서는 요약 및 결론을 맺는다.

II. 실험방법

2.1 모의 데이터 생성

선박 프로펠러의 회전으로 인해 발생하는 진폭 변조된 캐비테이션 소음은 선박 정보인 PSR, BR 등의 정보를 확인하기 위해 Fig. 1의 DEMON 분석 과정을 수행한다.

DEMON 분석은 먼저 선박 방사소음에 대역통과 필터를 적용하여 기계류 소음의 영향이 적고, 광대역 캐비테이션 신호가 우세한 주파수 대역의 신호를 추출한다. 그리고 진폭 변조된 신호를 복조하기 위해 포락선을 추출하고, DC 성분을 제거한다. 포락선을 추출한 신호에 존재하는 선박 정보는 낮은 주파수 대역에 존재하므로 저역 통과 필터 과정을 통해 고주파 신호를 제거하고, 시계열 신호를 주파수 영역의 신호로 변환하기 위해 FFT를 수행한다. 마지막으로 배경소음의 영향을 줄이기 위해 소음 규준화 과정을 수행한 후 DEMON 그램을 생성한다.

딥러닝 모델 학습에 사용할 모의 DEMON 그램을 생성하기 위해 진폭 변조된 광대역 캐비테이션 소음을 모의한 신호 를 사용하였고, 모의 신호 는 Eq. (1)로 표현된다.[10]

여기서 는 하모닉 차수의 길이, 는 변조 지수, 는 기본 주파수, 는 초기 위상(phase), 는 캐비테이션 소음 신호, 는 광대역 잡음이다. 모의 식의 기본 주파수는 PSR을 의미하며, 변조 지수 는 일반적으로 0.1에서 0.5 사이의 값을 가진다.

Eq. (1)을 사용하여 모의한 신호는 시간이 100 s, 샘플링 주파수가 32 kHz이며, 는 0.1 ~ 0.5 사이의 임의의 값을 지정하고, 는 표준정규분포를 따르는 난수로 설정하여 신호를 생성하였다. 그리고 프로펠러의 축이 1개인 선박이 등속운동하고 있는 경우를 가정하였다. 가정에 따라 모의된 신호는 실해역 데이터의 기계류 소음이 우세한 대역과 캐비테이션 소음이 최대로 확장되는 대역을 고려하여 대역통과 필터의 대역폭을 1 kHz ~ 10 kHz로 선정하고,[11] 저역 통과 필터의 차단 주파수를 100 Hz로 사용하였다. 저역 통과 필터를 통과하기 전에 연산량 감소를 위해 샘플링 주파수를 4 kHz로 다운샘플링을 수행하였으며, 주파수 분석 시 주파수 해상도가 1 Hz가 되도록 설정하였다. 위의 조건에 따라 DEMON 그램을 제작하여 모델 학습 데이터로 생성하고, 두 가지의 변동 인자를 고려하여 데이터를 제작하였다.

첫 번째로 해양환경에서 발생하는 소음들을 가산 백색 가우시안 잡음(Addictive White Gaussian Noise, AWGN)으로 가정하여 SNR이 –9 dB, –11 dB, –13 dB인 환경을 모의하였다. DEMON 분석의 소음 규준화 단계에서 모의 신호 내의 배경 소음의 영향을 줄이기 때문에 SNR이 0 dB로 낮은 경우에도 DEMON 그램 내 표적 주파수선이 선명하게 보인다. 따라서 표적 주파수선이 잘 보이지 않는 DEMON 그램을 모의하기 위해 SNR을 마이너스로 설정하였다. 위의 조건에 따라 제작된 모의 신호 중 기본 주파수를 10 Hz로 설정한 모의 신호로 만든 DEMON 그램에서 SNR이 낮아짐에 따라 표적 주파수선이 잘 이어지지 않는 것을 Fig. 2에서 확인할 수 있다.

본 연구에서는 SNR이 –13 dB인 모의 신호로 제작한 DEMON 그램을 낮은 SNR 환경에서 측정된 이미지로 설정하였다.

두 번째로 선박 속도에 따른 프로펠러 소음의 기본 주파수 및 DEMON 그램 내 표적 주파수선들의 간격 변동성을 모의하기 위해 기본 주파수를 4 Hz ~ 50 Hz 내에서 변경하며 신호를 생성하였다.

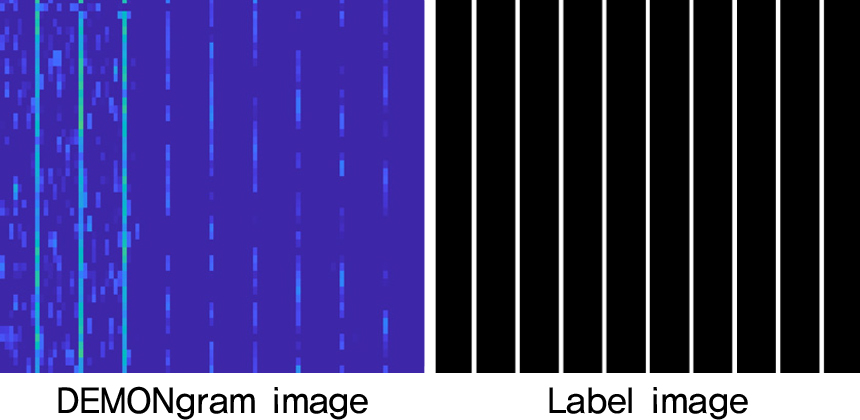

본 연구에서는 기본 주파수를 변경하며 SNR 별로 각 500개의 신호를 모의하여 총 1,500개의 모의 신호를 생성하고, 512 × 512 크기를 갖는 DEMON 그램 이미지로 변환하였다. 또한 SNR에 따라 생성된 모의 DEMON 그램 이미지의 데이터셋을 Table 1과 같이 분류하였다. DEMON 그램 정답 이미지의 화소들은 표적 주파수선에 해당하면 1, 나머지는 0인 이진값을 가지며 Fig. 3의 예시와 같다. 이렇게 생성된 DEMON 그램 이미지와 정답 이미지를 가지고 딥러닝 모델 학습에 사용하여 표적 주파수선을 추출하였다.

Table 1.

DEMONgram dataset.

| SNR | Image size | Total number of data | |

| –9 dB | 4 Hz ~ 50 Hz | 512x512 | 500 |

| –11 dB | 500 | ||

| –13 dB | 500 |

2.2 딥러닝 기법 및 적용 모델

학습 데이터로 사용되는 모의 DEMON 그램 이미지는 딥러닝을 사용하여 표적 주파수선을 추출할 수 있다. 이때 의미론적 분할 기법이 적용된 모델을 사용하여 낮은 SNR 환경에서 DEMON 그램 내 표적정보가 담겨있는 주파수선을 추출할 수 있다.

본 논문에서 사용된 의미론적 분할 모델은 U-Net,[12] UNet++,[13] DeepLabv3+[14]로 Fig. 4에서 각 모델의 모식도를 확인할 수 있다. 합성곱 신경망을 활용한 세 모델 중 U-Net은 ISBI 2015 Challenges 중 Cell Tracking Challenge에서 적은 수의 biomedical 이미지를 학습하여 가장 우수한 성능을 보여준 모델이다.[12] 이 모델은 인코더-디코더 구조를 사용하는데 인코더 구간은 합성곱 층과 맥스 풀링 층을 통해 입력받은 이미지의 특징들을 추출하여 특징 맵을 생성하고, 추출된 특징 맵의 크기를 감소시킨다. 디코더 구간은 합성곱 층과 업샘플링 층을 통해 인코더 구간에서 크기가 감소된 특징 맵을 원본 이미지 크기로 복원한다. 인코더-디코더 구조에서 각 층은 skip connection으로 연결되어 있는데 이는 디코더 층에 동일한 크기의 인코더 층을 연결하여 특징 맵의 크기가 감소하여 손실된 공간 정보를 복원하는 역할을 수행한다.

UNet++는 U-Net의 성능 향상을 위해 제안된 모델로 U-Net의 인코더-디코더 구조를 변형하여 사용한다.[13] U-Net에서 사용된 skip connection을 점진적으로 수행하는 re-designed skip pathways를 사용함으로써 medical 이미지 분할 시 기존 U-Net보다 우수한 성능을 보여준다.

DeepLabv3+는 의미론적 분할 모델 중 우수한 성능을 보여주는 모델로 인코더, Atrous Spatial Pyramid Pooling(ASPP), 디코더 구조로 구성되어 있다.[14] 인코더 부분은 Modified Aligned Xception을 사용하였다. Xception[15]은 이미지 분류 모델로 빠른 연산을 보여줬으며, Xception를 변형하여 객체 탐지 성능을 향상시킨 Aligned Xception[16]을 의미론적 분할이 가능하도록 수정한 Modified Aligned Xception을 사용하여 인코더의 입력 이미지의 특징을 추출하는 백본 네트워크로 사용한다. 백본 네트워크를 통해 나온 특징 맵에 커널 간격을 다르게 할당하여 이미지 정보들을 추출하고 이를 통합하는 ASPP를 사용한다. 그리고 앞선 두 모델과 마찬가지로 디코더 구간에서 skip connection을 사용하여 학습으로 인해 사라진 공간 정보를 복원한다. 이처럼 낮은 SNR 환경에서 선박 식별 및 분류 성능을 확보하기 위해 앞에서 살펴본 의미론적 모델인 U-Net, UNet++, DeepLabv3+에 모의 DEMON 그램 이미지를 학습하여 DEMON 그램 내 표적 주파수선을 추출하는 모델을 제작하였다.

2.3 실해역 데이터

모의 DEMON 그램 이미지로 학습한 세 가지 모델이 실제 해상환경에서 발생하는 선박 방사소음의 표적 주파수선 추출 가능성을 확인 및 비교하기 위해 본 논문에서는 2021년 공개된 데이터셋인 DeepShip을 사용하였다.[17] DeepShip은 2016년 5월부터 2018년 10월까지 선박 통행량이 많은 캐나다 조지아 해협에서 수신기 기준 2 km 범위 내 단일 선박만 존재할 때 측정한 선박 방사소음 데이터셋이다. 이때 자동식별시스템(Automatic Identification System, AIS)을 사용하여 Tug, Cargo, Passenger Ship, Tanker 4 종류의 선박으로 선박 방사소음을 분류하였다.

4 종류의 선박 중 Cargo를 표적 선박으로 선정하고, Cargo 선박 방사소음 신호를 DEMON 그램 이미지로 변환 후 등속운동하는 구간으로 추정되는 시간대를 추출하여 실해역 데이터로 사용하였다. 실해역 데이터인 DeepShip은 DEMON 분석 결과에서 확인할 수 있는 표적 주파수선이 실제 선박의 PSR, BR 정보와 정확한지 확인할 수 있는 선박 제원 정보가 존재하지 않는다. 따라서 실해역 데이터를 육안으로 분석하여 표적으로 추정되는 주파수선의 위치를 확인 후 정답 이미지를 생성하였다. 그 후 모의 데이터로 학습한 모델에 실해역 데이터를 넣어 모델들의 표적 주파수선 추출 성능을 정량적으로 확인할 수 있는 모델 평가 지표와 육안으로 모델들의 결과를 비교하는 정성평가를 수행하였다.

2.4 실험환경

본 연구에서 사용된 컴퓨터 환경은 다음과 같다. CPU는 AMD EPYC 7742, RAM은 1 TB, GPU는 NVIDIA RTX A6000 48 GB, OS는 Window Server 2022 Standard 환경에서 실험을 진행하였다. 모델 구현은 Python 3.8, Tensorflow 2.10.0 버전에서 진행하였다. 모델 학습 시 각 계층의 활성화 함수는 ReLU, 출력 함수는 Sigmoid, 최적화 알고리즘은 학습률을 0.01로 설정한 Stochastic Gradient Descent(SGD), 손실 함수는 Binary Cross Entropy를 사용하였으며, batch size는 10, Epoch는 300으로 학습하였다.

2.5 모델 성능 평가 지표

본 논문에서는 의미론적 분할 기법이 적용된 세 가지 모델을 사용하여 학습을 진행하였다. 학습된 모델을 사용하여 출력된 예측 이미지와 정답 이미지를 비교하기 위해 Table 2의 혼동 행렬을 사용하여 모델 성능을 확인하였다. 본 논문에서는 표적 주파수선에 해당하는 화소를 1(True), 배경에 해당하는 화소를 0(False)으로 설정하였다. 따라서 혼동 행렬의 TP(True Positive)는 모델이 예측한 이미지 중 특정 화소가 1이라고 예측하였을 때 정답 화소도 1로 정확하게 예측한 경우이며, False Negative(FN)는 모델이 특정 화소가 0이라고 예측하였을 때 정답 화소가 1로 잘못 예측한 경우이며, False Positive(FP)는 모델이 특정 화소가 1이라고 예측하였을 때 정답 화소가 0으로 잘못 예측한 경우이다. 마지막으로 True Negative(TN)는 모델이 특정 화소가 0이라고 예측하였을 때 정답 화소도 0으로 정확하게 예측한 경우이다.

본 연구에서 사용하는 모의 DEMON 이미지의 경우 모델 학습에 사용하는 정답 이미지의 대부분이 배경이고, 표적 주파수선은 이미지 중 극히 일부분이므로 TN 성분이 항상 높게 나왔다. 따라서 TN 성분을 반영하지 않고, 모델이 표적 주파수선을 잘 예측하는지 확인하는 지표로 Recall, Precision, F1-score를 사용하였다.[8] Recall은 실제 표적인 것 중에서 모델이 표적이라 예측한 비율로 Eq. (2)로 나타난다. 이는 DEMON 그램 내 실제 표적을 모델이 얼마나 잘 추출했는지 보여주는 지표로 표적 검출 확률을 보여준다. 하지만 배경을 표적으로 오인하는 FP 성분이 높게 나와도 Recall에 영향이 없어 이를 보완하기 위해 Precision과 F1-score를 사용하였다. Precision은 모델이 표적이라 예측한 것 중에서 실제 표적인 비율로 Eq. (3)으로 나타난다. F1-score는 Recall과 Precision의 성분을 모두 사용하는 지표로 Eq. (4)로 표현되어 진다. 이 세 가지 지표를 사용하여 모델이 표적을 잘 추출하는지 평가하였다.

III. 실험결과

3.1 모의 데이터 학습 모델 성능 평가

U-Net, UNet++, DeepLabv3+ 모델은 세 가지 SNR에 따른 모의 DEMON 그램 이미지를 모두 사용하여 모델 학습을 진행하였다. 학습 데이터는 6 : 2 : 2 비율로 훈련, 검증, 시험 데이터로 분리하였고, 훈련, 검증 데이터를 사용하여 모델 학습을 수행하였다. 학습된 모델은 시험 데이터를 사용하여 모델 평가를 수행하였고, 각 모델의 학습 결과는 Table 3에 정리하였다.

Table 3.

Model results – test data.

| Dataset | Epoch | Model | Recall | Precision | F1-score |

|

All SNR | 300 | U-Net | 0.8625 | 0.9968 | 0.9248 |

| UNet++ | 0.8611 | 0.9925 | 0.9221 | ||

|

Deep Labv3+ | 0.8491 | 0.9966 | 0.9170 |

Table 3의 학습 결과 중 Recall을 사용하여 모델 성능을 비교한 결과 U-Net, UNet++, DeepLabv3+의 Recall 지표가 각각 0.8625, 0.8611, 0.8491로 U-Net이 다른 모델보다 가장 높은 Recall 값을 가지고 있어 세 모델 중 표적 주파수선을 잘 추출한다. 그리고 세 모델 모두 Precision이 높게 나와 세 모델 모두 FP 성분이 낮다. 따라서 표적 검출 확률을 보여주는 Recall 지표와 Recall과 Precision의 조화평균인 F1-score 지표가 가장 높은 U-Net이 모의 DEMON 그램 내 표적 주파수선 추출 성능이 가장 우수하다.

시험 데이터를 SNR 별로 분리하여 각 모델의 학습 결과를 Table 4에 정리하였다. 세 모델 모두 SNR이 낮아짐에 따라 Recall 값도 낮아지는 것을 확인할 수 있다. SNR이 –9 dB, –11 dB인 경우 세 모델 간 Recall 값 차이가 별로 없었지만, SNR이 –13 dB일 때, U-Net의 Recall 값이 다른 모델보다 높아 낮은 SNR 환경에서 모의 DEMON 그램의 표적 주파수선을 잘 추출한다. 이는 모델 평가에 사용된 모의 DEMON 그램 중 기본 주파수가 10 Hz고, 세 가지의 SNR에 대한 각 모델의 표적 주파수선을 추출한 결과를 보여주는 Fig. 5에서 확인할 수 있다. 모의 DEMON 그램의 SNR이 –9 dB, –11 dB인 경우 세 모델 모두 표적 주파수선을 끊김없이 잘 추출하였다[Fig. 5(a), (b)]. SNR이 –13 dB인 모의 DEMON 그램 이미지의 경우 Recall 값이 가장 높았던 U-Net은 표적 주파수선의 추출 결과 주파수선의 끊김이 없었으며, UNet++는 약간의 주파수선의 끊김만 존재하였다. 반면 DeepLabv3+는 다른 모델보다 표적 주파수선의 끊김이 상대적으로 많았다[Fig. 5(c)].

Table 4.

Model results – test data by SNR.

3.2 실해역 데이터 예측 결과

모의 DEMON 그램 이미지로 학습한 세 모델에 실해역 데이터를 넣어 표적 주파수선의 추출 성능을 확인 및 비교하였다. 실해역 데이터의 DEMON 그램 이미지에서 표적으로 추정되는 주파수선의 간격이 넓은 경우와 좁은 경우로 나눠 각 모델 간 예측을 수행하였다[Fig. 6]. 그리고 평가 지표를 사용하여 각 모델의 예측 결과를 Table 5에 정리하였다.

Table 5.

Model results – cargo data.

먼저 실해역 데이터 중 기본 주파수가 26 Hz로 추정되는 DEMON 그램의 표적 주파수선 추출 결과를 각 딥러닝 모델별로 비교하였을 때 Recall 값은 DeepLabv3+, U-Net, UNet++ 순으로 낮아진다. 이는 DeepLabv3+가 다른 모델들보다 표적 주파수선을 잘 추출한 것을 의미한다. 하지만 Precision의 경우 DeepLabv3+가 가장 낮은 값을 가지며, 이는 DeepLabv3+가 다른 모델들과는 달리 표적 주파수선이 아닌 다른 주파수선들을 상대적으로 더 많이 추출한다. F1-score 결과를 비교하였을 때 UNet++, U-Net, DeepLabv3+ 순으로 낮아진다. 이는 UNet++과 U-Net이 기본 주파수가 26 Hz로 추정되는 실해역 데이터의 표적 주파수선 추출 성능이 우수한 것을 의미한다. Fig. 6(a)에서 기본 주파수가 약 26 Hz인 표적 주파수선 추출 결과를 육안으로 확인했을 때 모델 평가 지표와 마찬가지로 세 모델 모두 약간의 끊김은 있지만 표적 주파수선을 어느 정도 안정적으로 추출하였다. 그리고 세 모델을 비교했을 때 U-Net, UNet++ 보다 DeepLabv3+의 예측 결과에 표적 주파수선 외에 다른 선들이 더 많이 추출되었다.

다음으로 기본 주파수가 6 Hz로 추정되는 DEMON 그램의 표적 주파수선을 예측한 결과를 보면 세 모델의 Recall, Precision, F1-score 값이 기본 주파수가 약 26 Hz일 때 결과보다 낮아졌다. 이는 표적 주파수선의 끊김이 심하고, 표적 주파수선 외에 다른 주파수선들을 추출하는 것을 의미한다. 그리고 세 모델의 F1-score 결과를 비교하였을 때 U-Net, UNet++, DeepLabv3+ 순으로 값이 낮아진다. 이는 U-Net, UNet++ 모델이 기본 주파수가 6 Hz로 추정되는 실해역 데이터의 표적 주파수선 추출 성능이 우수한 것을 보여준다. Fig. 6(b)에서 기본 주파수가 약 6 Hz인 표적 주파수선의 추출 결과를 보여주는데 세 모델 모두 표적으로 추정되는 주파수선을 어느 정도 추출하지만 기본 주파수가 26 Hz로 추정되는 DEMON 그램보다 주파수선의 추출이 원만하지 않다. 이는 모델에 넣은 실해역 데이터의 특정 시간대 저주파 대역에서 표적 주파수선 외에 잡음도 존재하여 표적 주파수선이 잘 추출되지 않았다. 저주파 대역을 제외한 예측 이미지를 비교했을 때 U-Net, UNet++보다 DeepLabv3+의 결과에서 표적 주파수선이 끊어지는 정도가 심하였고, 세 모델 모두 표적 주파수선을 추출하지 못한 구간이 Fig. 6(a) 보다 많이 존재하였다.

IV. 요약 및 결론

본 논문에서는 낮은 SNR 환경에서 DEMON 그램 내 선박 정보가 담긴 표적 주파수선을 추출하기 위해 의미론적 분할 모델을 사용하였으며, 모의 데이터로 학습한 모델들을 사용하여 실해역 데이터의 표적 주파수선이 추출되는지 확인한 기초적인 연구이다. 모의 DEMON 그램 이미지를 가지고 모델을 학습하여 평가한 결과 가장 높은 F1-score 값인 0.9248을 가지는 U-Net의 성능이 우수하였다. 그 후 모의 DEMON 그램 이미지로 학습된 모델을 이용해서 실해역 데이터로 생성한 DEMON 그램의 표적 주파수선 추출 성능을 평가한 결과는 다음과 같다. 기본 주파수가 26 Hz, 6 Hz로 추정되는 DEMON 그램에서 세 모델 모두 표적 주파수선을 어느 정도 추출하였다. 세 모델 중에서 U-Net, UNet++가 실해역 데이터의 표적 주파수선 추출 성능이 우수한 것을 보여준다. 또한 저주파 대역에 잡음이 존재하는 기본 주파수가 6 Hz인 실해역 데이터의 DEMON 그램에서는 기본 주파수가 26 Hz일 때보다 표적 주파수선의 추출 성능이 낮았다.

기존 실해역 데이터의 DEMON 그램과 표적 주파수선 추출 모델의 DEMON 그램을 비교하면 다음과 같다. 실해역 데이터의 DEMON 그램은 잡음이 심한 저주파 구역에서 표적 주파수선 위치를 파악하는데 어려움이 존재 한다. 하지만 의미론적 분할 모델로 표적 주파수선을 추출한 DEMON 그램은 실해역 데이터의 DEMON 그램보다 상대적으로 잡음이 적으며, 주파수가 높은 대역의 표적 주파수선도 기존 DEMON 그램보다 잘 추출하는 것을 확인할 수 있다.

이번 연구에서는 선박이 등속운동하고, 프로펠러축이 1개만 존재한다고 가정하여 모의 데이터를 생성하였다. 실해역 데이터는 등속운동하고 있다는 가정을 위해 DEMON 그램 내 표적으로 추정되는 주파수선들이 시간에 따라 선형적으로 보이는 구간의 데이터를 선정하였다. 위의 조건에 맞는 기본 주파수가 26 Hz, 6 Hz로 추정되는 실해역 데이터를 육안으로 표적 주파수선의 위치를 분석하여 정답 이미지를 제작하고, 모델 예측을 수행하였다. 추후 실제 해역에서 선박 제원을 확인할 수 있는 선박을 사용하여 기본 주파수별로 등속운동하는 선박 방사소음 데이터를 측정하여 DEMON 그램과 정답 이미지를 제작하고 정확한 모델 성능 비교를 수행할 예정이다. 추가로 이번에 제작한 모의 데이터는 PSR만 고려하여 제작된 데이터이므로, BR도 고려하여 모의 데이터를 제작할 예정이다. 또한 가속운동에 따른 DEMON 그램 내 시간에 따른 표적 주파수선의 변화도 고려하여 모의 데이터 제작 및 학습을 수행할 예정이다. 마지막으로 표적 주파수선이 끊기는 현상은 다양한 학습 데이터의 추가, 다른 의미론적 분할 모델 사용 등의 방법으로 모델 성능을 향상시킬 수 있을 것으로 생각한다.